Thanks to technological advancements, our world is flattening and shrinking faster than ever before. As techies, we no longer need to travel or relocate to other parts of the globe in order to gain international and intercultural experiences, for they are literally served to our doorstep in the post-pandemic world. Thriving and leading in this new world of such rich diversity ironically calls for going back to the basics and practicing some time-tested principles. In this article, I have attempted to enumerate some of them, which I have witnessed and experienced both in real and virtual multinational settings.

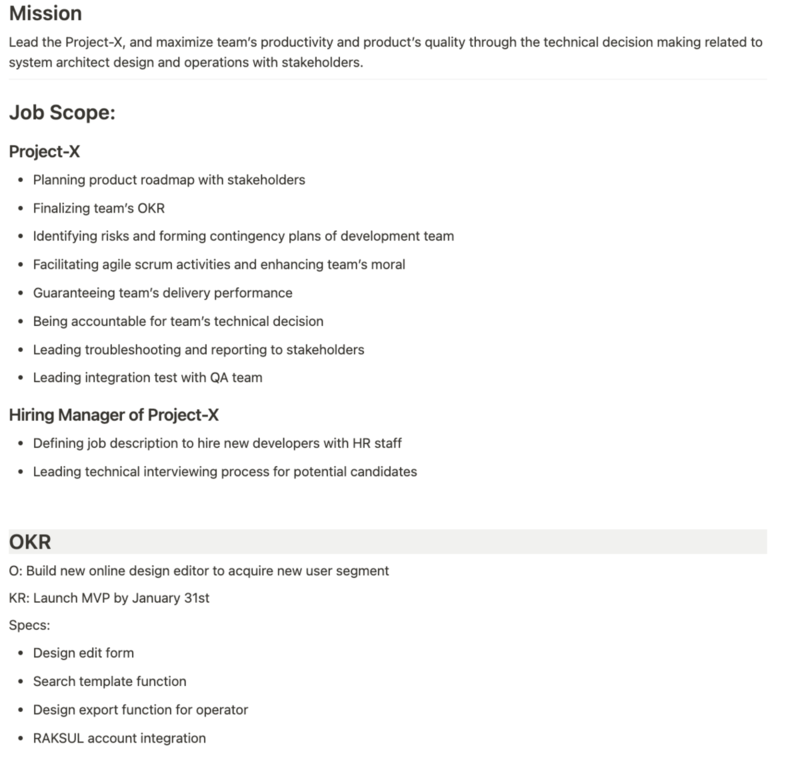

Execution

Grand visions and impressive strategies mean absolutely nothing without focused, disciplined and persevering execution. Execution is not glamorous, fanciful, or a nice and friendly job. It is being detail-oriented, thorough and obsessed with meeting commitments - every single time. Gaining leadership credibility by delivering high quality results, consistently, is only achieved by relentlessly and meticulously tracking everything and tying the loose ends on a daily basis. This is not to undermine delegation, but to emphasize the culture of delegating with accountability.

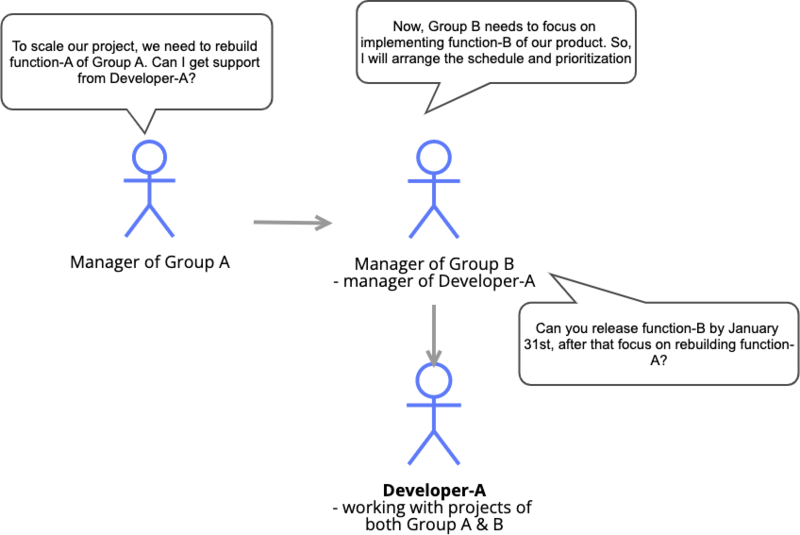

Conscientious Accountability

The culture of accountability transcends regional, cultural and language boundaries and promotes clarity, trust and team spirit. When we consistently hold ourselves and others accountable for committed results it sends a strong signal that our collective success is not optional and every single team member needs to contribute to it. As simple as it might seem, even good leaders need practice at assigning accountabilities crisply and unambiguously, clarifying expectations in terms of deliverables and timelines, giving heads-up on possible hurdles and pointing to sources of help if needed.

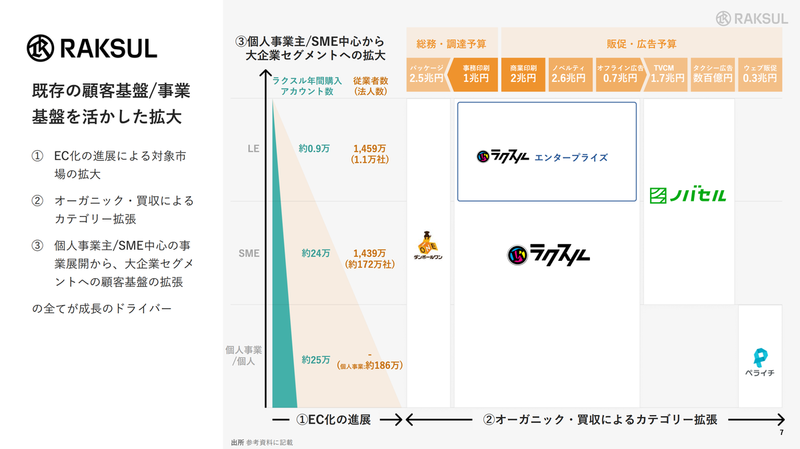

Teamwork for the business

Every corporate organization has its own vision, missions, goals and projects. Individual and leadership brilliance, charm, charisma, eloquence, foresight, etc. are rather inconsequential without a spirited team executing towards a common goal. A true leader acquires the right talent, motivates them to work as a team and aligns the team with the business goals. I used to work with a leader who would begin important meetings with a slide that just said “we are a business”, and this had the uncanny ability to orient everyone present. It basically meant we need to contribute every ounce of our energy for the business that relies on us; it implicitly conveyed that we are not a club, not a social organization, not a university, which all are completely different contexts.

Braving VUCA

It is a VUCA world out there. VUCA stands for Volatility, Uncertainty, Complexity and Ambiguity! Our world today is dynamic, fast, ruthless and waits for none! Technologies are changing, industries are being reinvented, companies are morphing; processes, ideas and beliefs are getting outdated… It needs us to be curious and open-minded. We need to observe externally, learn, unlearn, adopt and adapt very swiftly, just so that we don’t get left behind. To quote Albert Einstein, “In the middle of difficulty lies opportunity”.

Agree and commit or disagree and commit

This one is easier in some cultures than others; nevertheless, can’t be ignored in a global setting, in the knowledge industry. Some of the best, winning ideas emerge from multiple, diverse voices contributing, conflicting and collaborating. A golden rule that I learned from one of my previous managers is: “we discuss, debate, diverge and we finally agree and commit or we disagree and commit”. By doing this, leadership decision-making is never undermined and it is understood to be separate from discussion and debates.

Finding Purpose and Resonance

Better Systems, Better World! What an amazing sense of purpose! When a leader connects the team and what they do to such a resonating purpose, it galvanizes the team. Finding a sense of purpose at work can be extremely powerful! A job all of a sudden becomes a cause. This can lead us into a virtuous cycle of discovering new challenges, going beyond boundaries of the past, learning new things and achieving unexpected targets which in turn ensure perpetual engagement, excitement and progression.

Sanjay Rajasekhar CTO, Josys; President, RAKSUL India